Die Geschichte der Informatik

Einleitung

Die Informatik hat die Welt verändert. Sie hat den Alltag revolutioniert und ist nicht mehr aus unserer Gesellschaft wegzudenken. Ob in der Medizin, der Wirtschaft, der Forschung oder der Unterhaltung – die Digitalisierung und Automatisierung sind nicht nur technologische Fortschritte, sondern tiefgreifende kulturelle und soziale Umwälzungen. Die Entwicklung der Informatik ist ein faszinierender Weg, der uns von mechanischen Rechenmaschinen bis hin zu intelligenten Systemen führt, die das Denken und Handeln der Menschen beeinflussen. Diese Dokumentation zeigt die wichtigsten Etappen dieser Entwicklung und gibt einen Überblick über die bedeutendsten Erfindungen und Persönlichkeiten der Informatikgeschichte.

1. Die Anfänge der Informatik

1.1 Früheste Rechenhilfsmittel und der Beginn der Mathematik

Die ersten Schritte zur Informatik begannen nicht mit Computern, sondern mit einfachen Rechenhilfsmitteln. Schon in der Antike nutzten Menschen den Abakus, ein manuelles Gerät zum Zählen und Rechnen. Der Abakus war in verschiedenen Kulturen verbreitet, vor allem in Mesopotamien, China und Griechenland, und wurde zur Grundlage für komplexere mathematische und logische Systeme.

Im 17. Jahrhundert entwickelte der französische Mathematiker Blaise Pascal die erste mechanische Rechenmaschine, die Pascaline. Diese Maschine konnte einfache Addition und Subtraktion durchführen. Kurz darauf folgte Gottfried Wilhelm Leibniz, der das binäre Zahlensystem entwickelte, welches die Grundlage der modernen Informatik bildet. Heute wissen wir, dass die Verwendung von 0 und 1 zur Datenverarbeitung die Entwicklung der gesamten Computertechnologie ermöglichte.

1.2 Charles Babbage und Ada Lovelace – Der erste Computer

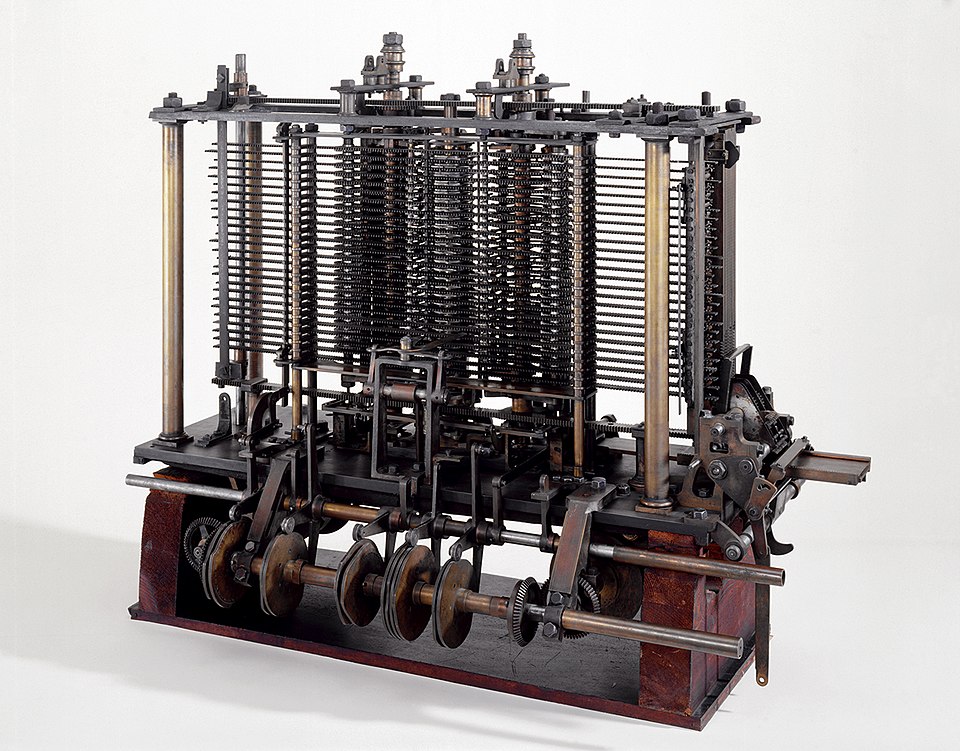

Im 19. Jahrhundert machte der britische Mathematiker Charles Babbage mit seiner Entwurfsarbeit zur Analytical Engine einen entscheidenden Schritt in der Geschichte der Informatik. Die Analytical Engine war die erste mechanische Rechenmaschine, die ein rudimentäres, programmierbares Steuerungssystem besaß. Sie galt als der Vorläufer des modernen Computers.

Die britische Mathematikerin Ada Lovelace arbeitete eng mit Babbage zusammen und erkannte als Erste das Potenzial von Babbages Maschine. Sie schrieb das erste Programm der Geschichte und entwickelte eine theoretische Grundlage für die Idee des "programmierten Rechnens". Siewird daher oft als die erste Programmiererin der Welt bezeichnet.

2. Die Ära der elektronischen Computer

2.1 Die ersten elektronischen Rechenmaschinen

Die Entwicklung der ersten elektronischen Computer begann in der ersten Hälfte des 20. Jahrhunderts. Während des Zweiten Weltkriegs bauten die USA den ersten elektronischen Universalcomputer, den ENIAC (Electronic Numerical Integrator and Computer). Der ENIAC war ein riesiger Rechner, der auf Vakuumröhren basierte und hauptsächlich für ballistische Berechnungen eingesetzt wurde.

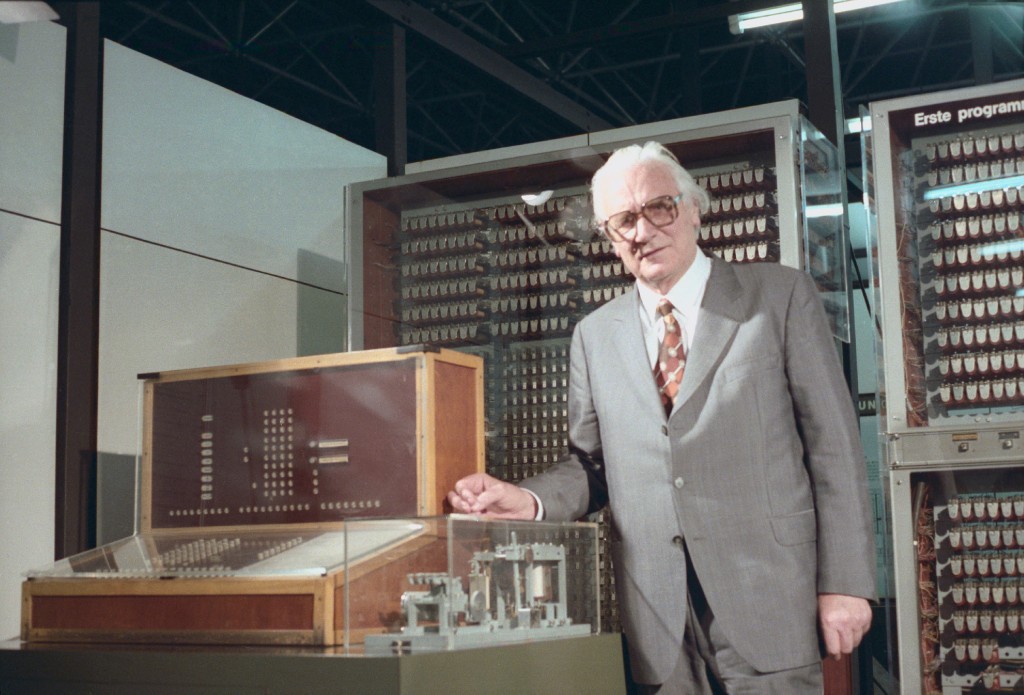

Gleichzeitig, aber unabhängig von den USA, entwickelte der deutsche Ingenieur Konrad Zuse die Z3, den ersten funktionstüchtigen, programmgesteuerten Computer. Die Z3 arbeitete mit Relais und zeigte bereits die Fähigkeit, allgemeine Berechnungen durchzuführen. Zuse gilt daher als einer der Pioniere der Informatik.

2.2 Die ersten Programmiersprachen und deren Entwicklung

Die ersten Computer arbeiteten ohne eine benutzerfreundliche Programmiersprache. Es gab nur maschinennahe Programmierung, was bedeutet, dass jeder einzelne Schritt direkt in maschinenverständlichem Code programmiert werden musste.

Im Jahr 1957 wurde jedoch die erste Programmiersprache für die allgemeine Nutzung entwickelt: Fortran (Formula Translation). Diese Programmiersprache wurde speziell für wissenschaftliche Berechnungen entwickelt und legte den Grundstein für viele der modernen Programmiersprachen.

Die Programmiersprache C wurde in den 1970er Jahren von Dennis Ritchie entwickelt und ist bis heute eine der bekanntesten und am häufigsten verwendeten Programmiersprachen weltweit.

3. Die Personal Computer Revolution

3.1 Die Entwicklung des Personal Computers

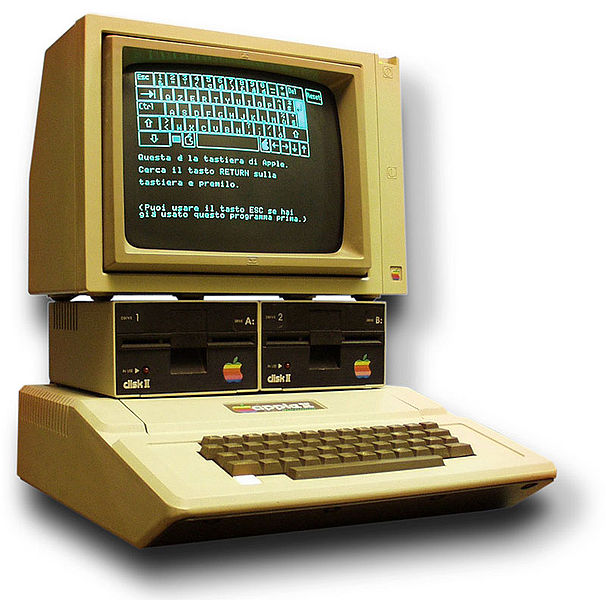

Die 1970er und 1980er Jahre brachten einen radikalen Wandel in der Computerwelt: die Entwicklung des Personal Computers (PC). Der revolutionäre Apple I, der 1976 von Steve Wozniak und Steve Jobs entwickelt wurde, zeigte, dass Computer nicht mehr nur riesige Maschinen in staatlichen Einrichtungen oder Unternehmen sein mussten. Der Apple II, der 1977 folgte, war der erste wirklich erfolgreiche Personal Computer.

Ein weiteres bedeutendes Ereignis war die Einführung des IBM-PC im Jahr 1981, der die PC-Industrie standardisierte und den PC weltweit populär machte.

3.2 Die Softwareindustrie und das Internet

Mit der zunehmenden Verbreitung von PCs wuchs auch die Softwareindustrie. Microsoft, das 1975 gegründet wurde, brachte 1981 das Betriebssystem MS-DOS für IBM-PCs auf den Markt. Kurz darauf, 1985, präsentierte Microsoft das Betriebssystem Windows, das die grafische Benutzeroberfläche (GUI) einführte und den Computermarkt revolutionierte.

Ende der 1980er Jahre begann auch das Internet an Bedeutung zu gewinnen. Tim Berners-Lee entwickelte 1991 das World Wide Web (WWW), das den weltweiten Austausch von Informationen revolutionierte. Dies war der Beginn des digitalen Zeitalters, in dem das Internet eine Schlüsselrolle in der globalen Vernetzung und Kommunikation einnahm.

4. Das digitale Zeitalter und die Zukunft der Informatik

4.1 Die Entstehung von Künstlicher Intelligenz

Im 21. Jahrhundert hat die Informatik enorme Fortschritte gemacht. Besonders die Entwicklung von Künstlicher Intelligenz (KI) und Maschinellem Lernen hat das Potenzial, sämtliche Branchen zu revolutionieren. Während KI in den 1950er Jahren als theoretisches Konzept begann, sind heute viele Anwendungen von KI im Alltag präsent – von spracherkennenden Systemen wie Siri und Alexa bis hin zu autonomen Fahrzeugen.

Ein prominentes Beispiel für KI ist der AlphaGo-Algorithmus von DeepMind, der 2016 den weltbesten Go-Spieler besiegte und damit die Leistungsfähigkeit moderner KI unter Beweis stellte.

4.2 Big Data, Cloud Computing und die Zukunft der Informatik

Ein weiteres bahnbrechendes Feld ist Big Data. Die Fähigkeit, riesige Datenmengen zu speichern und zu analysieren, hat die Art und Weise, wie Unternehmen arbeiten und forschen, revolutioniert. Cloud Computing ermöglicht es, Daten und Rechenleistung über das Internet bereitzustellen, was Unternehmen Flexibilität und Skalierbarkeit bietet.

Die Informatik wird auch die Quantencomputer-Technologie weiterentwickeln, die potenziell die Leistungsgrenzen klassischer Computer sprengen kann. In den kommenden Jahren könnten Quantencomputer Anwendungen in Bereichen wie Medizin, Materialwissenschaften und Klimaforschung auf völlig neue Weise ermöglichen.

Fazit

Die Informatik ist das Rückgrat der modernen Welt. Von den ersten mechanischen Rechenmaschinen bis hin zu den heutigen Technologien wie Künstlicher Intelligenz und Big Data hat sich die Informatik ständig weiterentwickelt. Die Zukunft der Informatik wird weiterhin faszinierend sein, mit Entwicklungen wie Quantencomputing und Blockchain, die die Technologiebranche in den kommenden Jahren noch stärker prägen werden.